Teoria de l'informacion

La teoria de l'informacion, sens precision, es le nom usual designant la teorie de l'informacion de Shannon, qu'es una teoria probabilista permetent de quantificar lo contengut mejan en informacion d'un ensemble de messatges, que lo codatge informatic satisfach una distribucion estatistica precisa. Aqueste domèni trapa son origina scientifica amb Claude Shannon que n'es lo paire fondator amb son article A Mathematical Theory of Communication publicat en 1948.

D'entre las brancas importantas de la teoria de l'information de Shannon, i a:

- lo codatge de l'informacion,

- la mesura quantitativa de redondança d'un tèxte,

- la compression de donadas,

- la criptografia.

Dins un sens mai general, una teoria de l'informacion es una teoria amb per objectiu de quantificar e qualificar la nocion de contengut en informacion present dins un ensemble de donadas. Atal, existís una autra teoria de l'informacion: la teoria algorithmica de l'informacion, creada per Kolmogorov, Solomonov e Chaitin al començament de las années 1960.

L'informacion segon Shannon, un concèpte de la fisica matematica

[modificar | Modificar lo còdi]L'informacion es un concèpte fisic novèl que sorgís dins un camp tecnologic. Lo concèpte teoric d'informacion foguèt introduch dempuèi de recercas teoricas suls sistèmas de telecomunicacion. L'origina d'aquestas recercas ven dels estudis menats a la fin del Sègle XIX, en fisica e en matematica per Boltzmann e Markov sus la nocion de probabilitat d'un eveniment e las possibilitats de mesura d'aquesta probabilitat. Mai recentament, abans la Segonda Guèrra mondiala, las contribucions mai importantas son degudas a la collaboracion dels matematicians e dels ingenhaires de las telecomunicacions, que foguèron menats a envisatjar las proprietats teoricas de tot sistèma de senhals utilizat pels èssers, vivents o tecnics, amb per objectiu la comunicacion.

Segon las òbras de Hartley (1928), Shannon (1948) determina l'informacion coma grandor mesurabla, senon observabla —que pas degun a jamai vist l'informacion— e aqueste ven lo saumièr de la teoria de la comunicacion que realiza amb Warren Weaver[1].

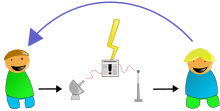

Aquesta teoria nasquèt de preoccupacions tecnicas practicas. La societat Bell cerca a transmetre los messatges de biais a l'encòp mai economic e mai fisable. Tanben l'encastre d'origina de la teoria es aqueste d'un sistèma de comunicacions o un emetor transmet un messatge a un receptor mejans un canal material/energetic donat. Emetor e receptor an per ipotèsi un repertòri comun, un còdi que conten las categorias de senhals utilisables. Atal lo messatge encodat es transmes, de l'emetor al receptor mejans lo canal, jos forma de signes o senhals portats per la matèria/energia.

Atal, lo concèpte d'informacion foguèt l'objècte d'una teoria que la posteritat causissèt de nomenar « teorie de l'informacion » alara que s'agiriá, de parlar verai, d'una teoria matematica de la comunicacion de l'informacion; mas aquesta expression es exactament aquesta de Shannon e Weaver ! Aquesta font de confusion es regularament mencionada dins la literatura. Se dich, en l'escasença, que l'expression abreujada foguèt retenguda per l'usatge; l'emplec del sigle TMCI clarificariá pasmens la situacion.

Aquesta teoria matematica aplicada a las tecnicas de la telecomunicacion foguèt realizada mai especialament per Claude Shannon, ingenhaire a la Companhiá dels Telefons Bell e demora fins ara la basa del concèpte dich scientific d'informacion. Pasmens, aquesyta teoria poiriá pas se piejar ni sus la forma materiala/energetica, ni sul contengut cognitiu dels messatges emeses: lor contengut semantic es daissat de costat, e tanben lor contenent fisic, per s'interessar pas qu'als aspèctes matematics e comunicacionals.

Dins sa concepcion originala, la teoria de l'informacion de Shannon se limitèt a analisar los mejans de realizar dins las tecnicas de telecomunicacion per transmetre l'informacion mai avidament possible e amb mai de seguretat. S'esforcèt dons de desvelopar de metòdes susceptibles de minimizar la probabilitat d'error dins la reconeissença del messatge. Una nocion fondamentala serà necessària per desvelopar aquestes metòdes: la mesura de l'informacion, al sens matematic del tèrme.

Per Shannon, l'informacion presenta un caractèr subretot aleatòri. Un eveniment aleatòri es per definicion pas segur. Aquesta incertitud es presa coma mesura de l'informacion. Una informacion serà donc unicament definida per sa probabilitat (I = - log p). Donc l'informacion es la mesura de l'incertitud calculada a partir de la probabilitat de l'eveniment. Shannon a donc confondut la nocion d'informacion e de mesura d'incertitud. Cal remarcar que dins aquesta definicion l'informacion es plan sinonime de mesura d'incertitud. Dins aqueste òrdre d'idèa, mai una informacion es incertana, mai es interessanta, e un eveniment segur conten pas cap d'informacion. En teoria de l'informacion de Shannon, s'agís donc de rasonar en probabilitat e non pas en logica pura.

L'informacion de Shannon se mesura en unitats binaras dichas bits. Lo bit se pòt definir coma un eveniment que desnosa l'incertitud d'un receptor plaçat fàcia a una alternativa que ambedoas eissidas son per el equiprobablas. Mai las eventualitats que pòt envisatjar aqueste receptor son nombrosas, mai lo messatge ten d'eveniments informatius, mai creis la quantitat de bits transmes. Es clar que pas cap de receptor mesura en bits l'informacion obtenguda dins un messatge. Es solament lo constructor d'un canal de telecomunicacion qu'a besonh de la teoria, e mesura l'informacion en bits per far la transmission de messatge mai economica e mai fiasbla possibla.

La nocion d'informacion segon Shannon es necessàriament associada a la nocion de « redondança » e a aquesta de « bruch ». Per exemple, en linguistica l'informacion es ni dins lo mot, ni dins la sillaba, ni dins la letra. I a letras veire de sillabas que son inutilas a la transmission de l'informacion que conten lo mot: i a dins una frasa, de mots inutils a la transmission de l'informacion. La teoria de Shannon nomena redondança tot çò que dins lo messatge apareis coma en demai. Alara es economic de transmetre pas la redondança.

L'informacion camina mejans un canal material/energetic: fial telefonic, onda radio, etc. Mas, dins son caminament, l'informacion encontra de bruch. Lo bruch es constituit per las perturbacions aleatòrias de totas menas que sorgisson dins lo canal de transmission e tendon a trebolar lo messatge. Lo problèma de la degradacion de l'informacion pel bruch es donc un problèma inerent a sa comunicacion. Aicí, l'idèa de redondança presenta una fàcia novèla; alara qu'apareis coma un demai inutil jol vejaire economic, ven, del viajaire de la fiabilitat de la transmission un fortificant contra lo bruch, un preventiu contra los riscs d'ambiguïtat e d'error a la recepcion.

L'estatut fisic de la teoria de l’informacion

[modificar | Modificar lo còdi]Lèu fòrça aplicacions de la teoria de l'informacion de Shannon apareguèron dins lo domèni de las sciéncias umanas[2]: los modèls matematicas elaborats permetèron de precisar de concèptes utilizats de biais corrent dins los analisis linguistics estructurals, al mèsme temps que fasián aparéisser las limitas inerentas a aqueste tipe d'analisi e provocavan de recercas novèlas (en traduccion automatica e en psicolinguistica). Alara que se desvolopavan un camp scientific novèl: la cibernetica[3].

Pasmens, una caracteristica majora de la teoria de Shannon es de donar a la nocion d'informacion (tal que definida per aquesta teoria) un estatut fisic d'esperela. Efectivament, l'informacion pren los caractèrs fondamentals de tota realitat fisica organizada: abandonada a e la mèsma, pòt evoluir pas que dins lo sens de sa desorganisacion, e a dire la creissença d'entropia; de fach, l'informacion subís, dins aquestas transformacions (codatge, transmission, descodatge, etc.), l'efièch irreversible e creissent de la degradacion. En consequéncia Shannon definís coma entropia d'informacion la mesura H ( H = - K log p). De biais susprenent, l'equacion per que Shannon definís l'entropia de l'informacion coïncidìs, masde signe invèrs, amb l'equacion de Boltzmann-Gibbs definissent l'entropia S en termodinamica (S = K log p). Aqueste episòdi important foguèt fòrça comentat[4].

Unes, coma Couffignal[5], sostenguèron que la coïncidéncia es sens signifiacion: l'aplicacion de la foncion de Shannon a la termodinamica e a l'informacion seriá un azard d'encontra de l'aplicacion d'una mèsma formula matematica, pas res pus. De segur, pòt i aver encontre de doas equacions de probabilitat venent d'universes diferents.

al contrari, Brillouin aviá pretendut establir una relacion logica entre la H de Shannon e la S de Boltzmann, çò que retenguèt gaireben totes los cercaires qu'aplican la teoria a las disciplinas non matematicas, la biologia sobretot Segon aqueste vejaire, es possible d'inscriure l'informacion tot coma la definís Shannon dins la fisica. En efièch, existís una dualitat dins lo concèpte d'informacion ligant l'informacion a la matèria/energia veïculant aquesta informacion. L'informacion tal coma definida per Shannon s'enrasiga atal dins la fisica d'un costat, dins las matematicas d'autre, mas sens que se pòscala reduire als mèsres-concèptes de la fisica classica: massa e energia. Coma lo dich Wiener: «l'informacion es ni la massa, ni l'energia, l'informacion es l'informacion», çò que dobrís las concepcions diferentas, a començar per aquesta d'un tresen constituent de l'univèrs[6], après la matèria e l'energia precisament!

Desvelopament de la teoria matematica de l'informacion

[modificar | Modificar lo còdi]La teoria matematica de l'Informacion resulta d'en primièr d'òbras de Ronald Aylmer Fisher. Aqueste, estatistician, definís formalament l'informacion coma egala a la valor mejana del carrat de la derivada parciala (δ) del logaritme natural de la lei de probabilitat estudiada.

A partir de l'inegalitat de Cramer, se deduch que la valor d'una tala informacion es proporcionala a la feble variabilitat de las conclusons resultantas. En tèrmes simples, mens una observacion es probabla mas es portaira d'informacion. Per exemple, quand lo jornalista comrnça lo jornal televizat per la frasa « Bonser », aqueste mot, que presenta una fòrta probabilitat, dona pauc d'informacion. Mas, se la primière phrasa es, per exemple « Modèl:Page hLa França a paur », sa feble probabilitat farà que l'auditor aprendrà que quicòm se passèt, e, alara, serà mai a l'escocha.

D'autres modèls matematicas completèron e espandiguèron de biais formal la definicion de l'informacion.

Claude Shannon e Warren Weaver enfòrçan lo paradigme. Son engenhaire en telecomunicacion e se preoccupan de mesurar l'informacion per ne deduire los fondamentals de la Comunicacion (e non pas una teoria de l'informacion). Dins Teoria Matematica de la Comunicacion en 1948, modelizan l'informacion per estudiar las leis correspondantas : bruch, entropia e caòs, per analogia generala a las leis d'energetica e de termodinamica. Lors òbras completant aquestas d'Alan Turing, de Norbert Wiener e de John von Neumann (e mai) bastisson lo lindal inicial de la teoria del senhal e de las « Sciéncias de l'Informacion ».

Per una font comportant simbòls, un symbòl avent una probabilitat d'aparéisser, l'entropia de la font es definida coma:

Es al començament que lo logaritme natural qu'es utilizat. Serà remplaçat per comoditat pel logaritme de basa 2, correspondent a una informacion qu'es lo bit. Las consideracions d'entropia maximala (MAXENT) permetràn a l'inferéncia bayesian de definir de biais racional sas distribucions a priori.

L'informatica constituarà una declinason tecnica automatizant los tractaments (que la transmission e lo transpòrt) d'informacion. Lo nom « Tecnologias de l'Informacion e de la Comunicacion » recobrís los diferents aspèctes (sistèmas de tractaments, rets, etc.) de l'informatica al sens larg.

Las sciéncias de l'informacion enlusisson de sens dempuèi las donadas en se piejant sus de questions de correlacion, d'entropia e d'aprendissatge (Data mining). Las tecnologias de l'informacion, elas, s'ocupan del biais de concebre, implementar e desplegar de solucions per respondre e de besonhs identificats.

Adrian Mc Donough dins Information economics definís l'informacion coma l'encontre d'una donada (data) e d'un problème. La coneissença (knowledge) es una informacion potenciala. Lo rendiment informacional d'un sistèma de tractament de l'informacion es lo quocient entre lo nombre de bits de la sèrva de donadas e aquestas de l'informacion extracha. Las data son lo cost side du sistèma, l'informacion, lo value side. Ne resulta que quand informatician calcula la productivitat de son sistèma al rapòrt entre la quantitat de donadas produchas e lo cost financièr, comet una error, qu'ambedos tèrmes de l'equacion negligisson la quantitat d'informacion realament producha. Aquesta remarca pren tot son sens a la lutz del grand principi de Russell Ackoff que postula qu'a delà d'una cèrta massa de donadas, la quantitat d'informacion bassa e qu'a la limita ven nula. Aquò correspond a dich « tròp d'informacion gasta l'informacion ». Aquesta constat es agravat quand lo receptor del sistèma es un processor uman, e pièger, lo conscient d'un agent uman. En efièch, l'informacion es tributari de la seleccion operada per l'atencion, e per l'intervencion de donadas afectivas, emocionalas, e estructuralas absentas de l'ordinator. L'informacion se transforma alara en sens, puèi en motivacion. Una informacion que produch pas cap de sens es nula e avalida pel receptor uman, quitament s'es acceptabla per un robot. Una informacion cargada de sens mas non asagada per una energia psicologica (drive, cathexis, libido, ep, etc.) es mòrta. Se constata donc que dins la cadena que mèna de la donada a l'accion (donadas → informacion → coneissença → sens → motivacion), solas las doas primièras transformacions son utilizadas per teoria de l'informacion classica e per la semiologia. Kevin Bronstein remarca que l'automata definís l'informacion pas que par doas valors: lo nombre de bits, l'estructura e l'organizacion des semas, alara que lo psiquisme fa intervenir de factors dinamics coma passion, motivacion, desir, repulsion, etc. que donan vida a l'informacion psicologica.

Exemples d'informacion

[modificar | Modificar lo còdi]Una informacion designa, d'entre un ensemble d'eveniments, un o mai eveniments possibles.

En teoria, l'informacion merma l'incertitud. En teoria de la decision, se considèra quitament que cal nomenar « informacion » que çò qu'es « susceptible d'aver un efièch sus nòstras decisions ».

En practica, l'excès d'informacion, tal que se presenta dins los sistèmas de corrièr electronic, pòt manar a una saturacion, e empachar la presa de decision.

Primièr exemple

[modificar | Modificar lo còdi]Siá una font podent produire de tensions entièras de 1 à 10 volts e un receptor que va mesurar aquesta tension. Abans lo mandadís del corrent electric per la font, lo receptor a pas cao idèa de la tension que serà liurada per la font. Mas, un còp lo corrent emes e recebut, l'incertitud sul corrent emes diminuís. La teorie de l'informacion considèra que lo receptor possedís una incertitud de 10 estats.

Segond exemple

[modificar | Modificar lo còdi]Una bibliotèca possedís un grand nombre d'obratges, de revistas, de libres e de diccionaris. Cercam una leiçon complèta sus la teoria de l'informacion. D'en primièr, es logic qu'encontraram pas aqueste dossièr dis d'obratges d'arts o de literatura; venèm donc d'obténer una informacion que diminuirà nòtre temps de recerca. Aviam precisat que tanben voliam una leiçon complèta, lo trobaram donc ni dins una revista, ni dins un diccionari. Avèm obtengut una informacion de mai (cercam un libre), que reduirà encara lo temps de nòstra recerca

Informacion imperfiècha

[modificar | Modificar lo còdi]Siá un realisator qu'ami dos films sus tres. Un critica que coneissi plan agonís son darrièr film e sabi que partatgi en mejana los analisis d'aqueste critica quatre còps sus cinc. Me dissiudirà aquesta d'anar veire lo film? Aquí es la question la question centrala de l'inferéncia bayésiana, que se quantifica tanben en bits.

Contengut d'informacion e contèxte

[modificar | Modificar lo còdi]Pren mens de bits per escriure « can » que « mamifèr ». Pourtant l'indication « Medor es un can » conten mai d'informacion que l'indicacion « Medor es un mamifèr »: lo contengut d'informacion semantic d'un messatge depend del contèxte. De fach, es lo parelh messatge + contèxte que constituís lo verai portaire d'informacion, e jamai lo messatge sol (veire paradòxe del compressor).

Mai, lo quita mot de « messatge » a de sens que se postula un emetor (conscient o non, per exemple un fenomèn creant d'ondas gravitacionalas) e un receptor o real (LIGO) o ipotetic (per exemple messatge d'un naufragat plaçat dins una botelha), en mai de las informacions de contèxte: lenga, diccionari, gramatica.

Mesura de la quantitat d'informacion

[modificar | Modificar lo còdi]Quantitat d'informacion: cas elementari

[modificar | Modificar lo còdi]Consideram bòstias numerotadas de 1 a . Un individú A amaguèt a l'azard un objècte dins una d'aquestas bòstias. Un individú B deu trobar lo numèro de la bòstia ont es amagat l'objècte. Per çò far, pòt puasar de questions a l'individú A qu'aqueste deu respondre sens mentir per ÒC o NON. Mas cada question pausada còstas a l'individú B (per exemple 1€). Un individú C sap dins quina bòstia es amagat l'objècte. Ten la possibilitat de vendre aquesta informacion a l'individú B. B acceptarà aqueste mercat pas que se lo còst de C es inferior o egal al còst mejan que B deuriá depensar per trobar la bòstia pausant de questions a A. L'informacion tenguda per C a donc un cèrt pretz. Aqueste prètz representa la quantitat d'informacion representada per la coneissença de la bona bòstia: es lo nombre mejan de questions a pausar per identificar aquesta bòstia. La notaram I.

EXEMPLE :

Se , . I a qu'una sola bòstia. Pas cap de question es necessària.

Se , . Se demanda se la bona bòstia es la bòstia no . La responsa ÒC o NON determina alara sens ambiguïtat quina es la bòstia cercada.

Se , . Se demanda se la bòstia pòrta lo no o 2. La responsa permet alara d'eliminar doas de las bòstias e sufís d'una darrièra question per trobar quina es la bona bòstia d'entre las doas que demoran.

Se , . S'escriu los numèros de las bòstias en basa 2. Los numèros an al mai chifres binaris, e per cadun dels rengs d'aquestes chifres, se demanda se la bòstia cecada possedís lo chifre 0 o lo chifre 1. En questions, se determinèt totes los chiffres binars de la bona bòstia. Aquò torna a pausar questions, cada question avent per objectiu de divisar successivament lo nombre de bòstia consideradas per 2 (metòde de dicotomia).

Ne venèm donc apausar , mas aquesta configuracion se realiza pas que dins lo cas de eveniments equiprobables.

Quantitat d'informacion relativa a un eveniment

[modificar | Modificar lo còdi]Supausam ara que las bòstias sián coloradas, e qu'i aja bòstias rojas. Supausam tanben que C sapia que la bòstia ont es amagat l'objècte es roja. Quin es lo prètz d'aquesta informacion? Sens aquesta informacion, lo pretz de pagar es . Amb aquesta informacion, lp pretz de pagar es alara pas que . Lo pretz de l'informacion « la bòstia cercada es roja » es donc .

Se definís atal la quantitat d'informacion coma una foncion creissenta de amb:

- lo nombre d'eveniments possibles

- lo nombre d'elemnts del sosensemble delimitat per l'informacion

Per mesurar aquesta quantitat d'informacion, pausam:

es exprimit en bit (o « logon », unitat introducha per Shannon que de fachs, bit es un sinonime), o alara en « nat » s'utilizam lo logaritme natural a la plaça del logaritme de basa 2.

Aquesta definicion se justifica, que se vòl las proprietats seguentas:

- l'informacion es comprisa entre 0 e ∞;

- un eveniment amb pauc de probabilitat representa fòrça informacions (exemple: « cai de nèu en genièr » conten fòrça mens d'informacion que « cai de nèu agost » quand sèm dins l'emisfèri nòrd);

- l'informacion deu èsser additiva.

Remarca: quand dispausam de fòrça informacions, la quantitat d'informacion globala es pas la soma de las quantitats d'informacion. Aquòse deu a la preséncia del logaritme. Vejatz tanben : informacion mutuala, informacion comuna a dos messatges, que, dins l'idèa, explica aquesta « sosadditivitat » de l'informacion.

Entropia, formula de Shannon

[modificar | Modificar lo còdi]Supausam ara que las bòstias sián de diferentas colors: n1 bòstias de color C1, n2 bòstias de color C2…, nk bòstias de colors Ck, amb n1 + n2 + … + nk = N. La persona C sap de quina color es la bòstia cercada. Quin es lo pretz d'aquesta informacion?

L'informacion « la bòstia es de color C1 » val log N/n1, e aquesta eventualitat a una probabilitat n1/N. L'informacion « la bòstia es de color C2 » val log N/n2, e aquesta eventualitat a una probabilitat n2/N…

Lp pretz mejan de l'informacion es donc n1/N log N/n1 + n2/N log N/n2 + … + nk/N log N/nk. Mai generalament, se consideram k eveniments disjonchs de probabilitats respectivas p1, p2…, pk amb p1 + p2 + … + pk = 1, alara la quantitat d'informacion correspondent a aquesta distribucion de probabilitat es p1 log 1/p1 + … + pk log 1/pk. Aquesta quantitat se nomena entropia de la distribucion de probabilitat.

L'entropia permet donc de mesurar la quantitat d'informacion mejana d'un ensemble d'eveniments (subretot de messatges) e de mesurar son incertitud. Es notada :

amb la probabilitat associada a l'aparicion de l'eveniment .

Codatge de l'informacion

[modificar | Modificar lo còdi]On considère une suite de symboles. Chaque symbole peut prendre deux valeurs s1 et s2 avec des probabilités respectivement p1 = 0,8 et p2 = 0,2. La quantité d'information contenue dans un symbole est : Se cada simbòl es independent del seguent, alara un messatge de N simbòls conten en mejana una quantitat d'informacion egala a 0,72N. Se lo simbòl s1 es codat 0 e lo simból s2 es codat 1, alara lo messatge a una longor de N, çò qu'es una pèrda al respècte de la quantitat d'informacion que pòrta. Los teorèmas de Shannon enoncian qu'es impossible de trobar un còde que la longor mejana siá inferiora a 0,72N, mas qu'es possible de codar lo messatge de biais que lo messatge codat aja en mejana una longor tan pròcha que se vòl de 0,72N quand N aumenta.

Per exemple, s'amaga los simbòls tres per tres e se los còda atal:

| simbòls de codar | probabilitat del triplet | codatge del triplet | longor del còde |

|---|---|---|---|

| s1s1s1 | 0,8³ = 0,512 | 0 | 1 |

| s1s1s2 | 0,8² × 0,2 = 0,128 | 100 | 3 |

| s1s2s1 | 0,8² × 0,2 = 0,128 | 101 | 3 |

| s2s1s1 | 0,8² × 0,2 = 0,128 | 110 | 3 |

| s1s2s2 | 0,2² × 0,8 = 0,032 | 11100 | 5 |

| s2s1s2 | 0,2² × 0,8 = 0,032 | 11101 | 5 |

| s2s2s1 | 0,2² × 0,8 = 0,032 | 11110 | 5 |

| s2s2s2 | 0,2³ = 0,008 | 11111 | 5 |

Lo messatge s1s1s1s1s1s2s2s2s1 serà codat 010011110.

La longor mejana del còde d'un messatge de N simbòls es:

Limitas d'aquesta teoria

[modificar | Modificar lo còdi]Une de las caracteristicas fondamentalas d'aquesta teoria es l'exclusion de la semantica. La teoria de l'informacion es indiferenta a la significacion dels messatges. Lo sens d'un messatge pòt pasmesn èsser considerat coma essencial dins la caracterizacion de l'informacion. Mas lo punt de vista de la teoria de l'informacion se limita a aqueste d'un messatgièr que la foncion es de transferir un objècte[7] .

La teoria de l'informacion de Shannon es sempre relativa a un ensemble de donadas, una familha de cadenas de caractèrs, caracterizada per una lei de distribucion plan prescisa. Dona donc un contengut en informacion en mejana, çò que ne fa una teoria probabilista, particularament plan adaptada al contèxte de la transmission de donada, e dins aqueste encastre aquesta teoria produguèt de resultats importants. Pasmens, es pas en mesura de quantificar lo contengut en informacion d'una cadena presa de biais isolat, un brot d'ADN per exemple, alara que la teoria algoritmica de l'informacion n'es capable fins a cèrt punt. Mas aquesta darrièra teoria possedís tanben las sieunas limitacions. Es perque cal pas considerar que la nocion d'informacion es entièrament cernada per la teoria de l'informacion de Shannon, o la teoria algoritmica de l'informacion, mas qu'aquesta nocion a besonh d'una varietat de modelizacions formalas per s'exprimir[8].

L'informacion de Fisher sembla tanben a vegada de biais avantatjós remplaçar l'informacion de Shannon dins la mesura ont es una quantificacion locala e non globala de l'informacion contenguda dins una distribucion[9]. Pasmens, ambedoas nocions son ligadas[10] e pòdon dins diferentas aplicacions menar als mèsmes resultats.

Nòtas e referéncias

[modificar | Modificar lo còdi]- ↑ C.E. Shannon et W. Weaver : The mathematical Theory of communication, University of Illinois, Urbana III, 1949.

- ↑ Voir par exemple, R. Escarpit : Théorie générale de l'information et de la communication, Hachette 1980.

- ↑ La cybernétique naquit en happant le concept scientifique d'information naissant pour l'intégrer dans la théorie des machines. La cybernétique est une discipline entamée par Norbert Wiener en 1948. Elle est définie comme étant l'étude de la théorie de la commande et de la communication tant dans la machine que dans les êtres vivants. En effet, dans la conception de Wiener, la cybernétique n'est pas seulement une science des machines mais s'intéresse à tout système, vivant ou non, capable d'auto-contrôle et de communication. Ainsi Wiener fonda la cybernétique en liant la commande à la communication de l'information.

- ↑ Jérôme Segal. Le zéro et le un. Histoire de la notion scientifique d'information au Modèl:20e. Éditions Syllepse, 2003, 890 p. ISBN: 2 84797 046 0. James Gleick. The information. A history, a theory, a flood. Fourth Estate, 2011, 527 p. ISBN: 978 0 00 722574 3.

- ↑ L. Couffignal : La cybernétique, PUF, Que sais-je ?, Paris 1968.

- ↑ Doyle, R. (Bob) et "The Information Philosopher" : www.informationphilosopher.com (I-Phi ou Pi). Stonier, T. Information and the internal structure of the universe. Springer Verlag, 1990. Beyond information. The natural history of intelligence. Springer Verlag, 1992.

- ↑ Université de Tours, vue d'ensemble de la théorie de l'information, page 5

- ↑ Modèl:Information, complexité et hasard Chapitre 1

- ↑ B.R.Frieden, Science from Fisher Information, 2004, Cambridge University Press

- ↑ C.R.Rao, Differential Metrics in Probability Spaces in Differential Geometry in Statistical Inference, Chapitre 5, Institute of Mathematical Statistics

Vejatz tanben

[modificar | Modificar lo còdi]Bibliografia

[modificar | Modificar lo còdi]- Léon Brillouin Science et théorie de l'information, J. Gabay, 2000 ISBN: 2876470365

- Léon Brillouin Science and information theory (typographie plus lisible, mais version en anglais)

- (en) PDF C. E. Shannon . (Reprinted with corrections from The Bell System Technical Journal, Vol. 27, p. 379–423, 623–656, July, October, 1948.)

- Modèl:CoverThomas06

- Modèl:MacKay

![{\displaystyle {\mathcal {I}}(\theta )=\mathrm {E} \left\{\left.\left[{\frac {\partial }{\partial \theta }}\ln L(X;\theta )\right]^{2}\right|\theta \right\}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/133354dfdbcc644a38e6439c187810ba1ec45135)